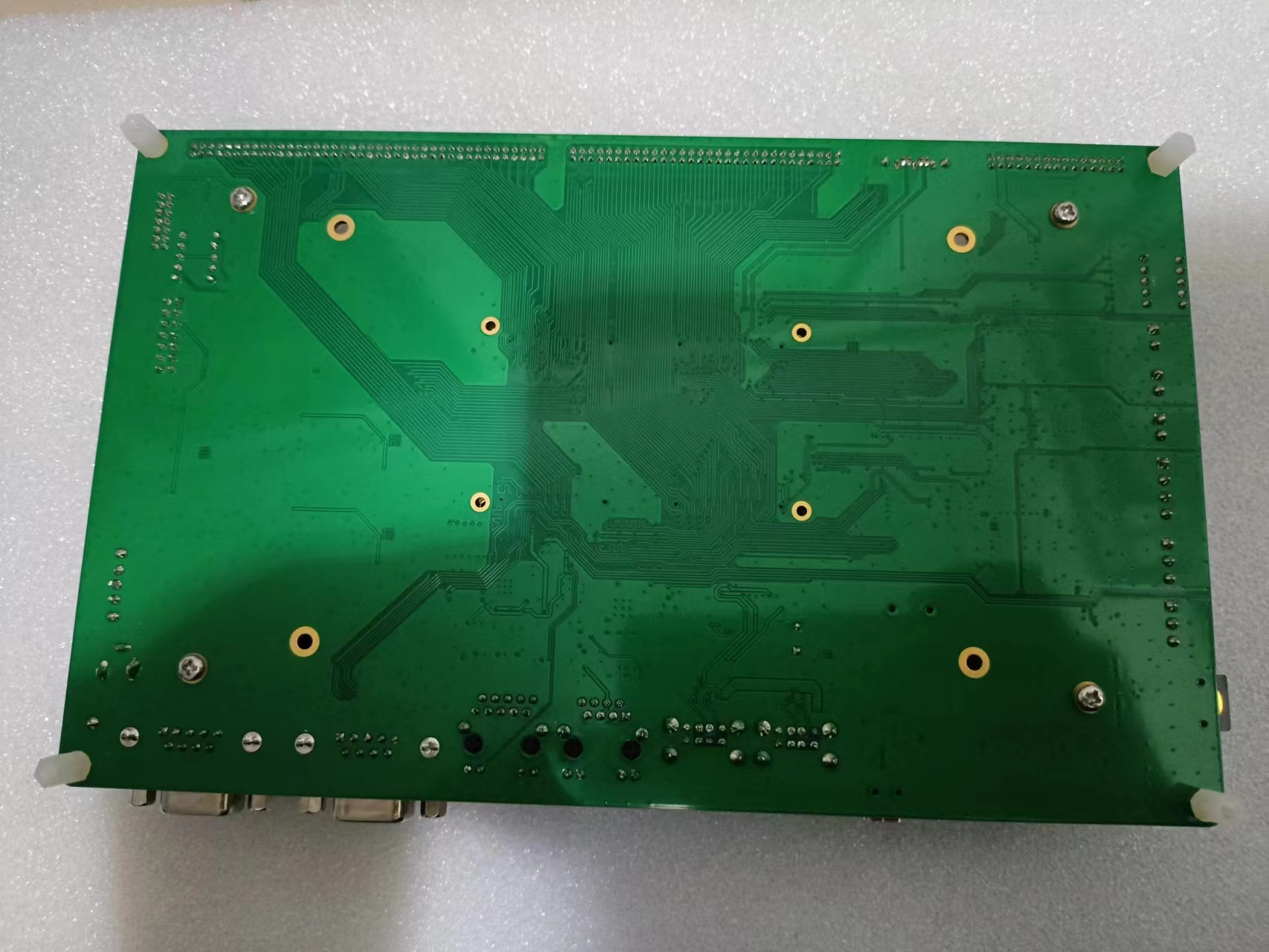

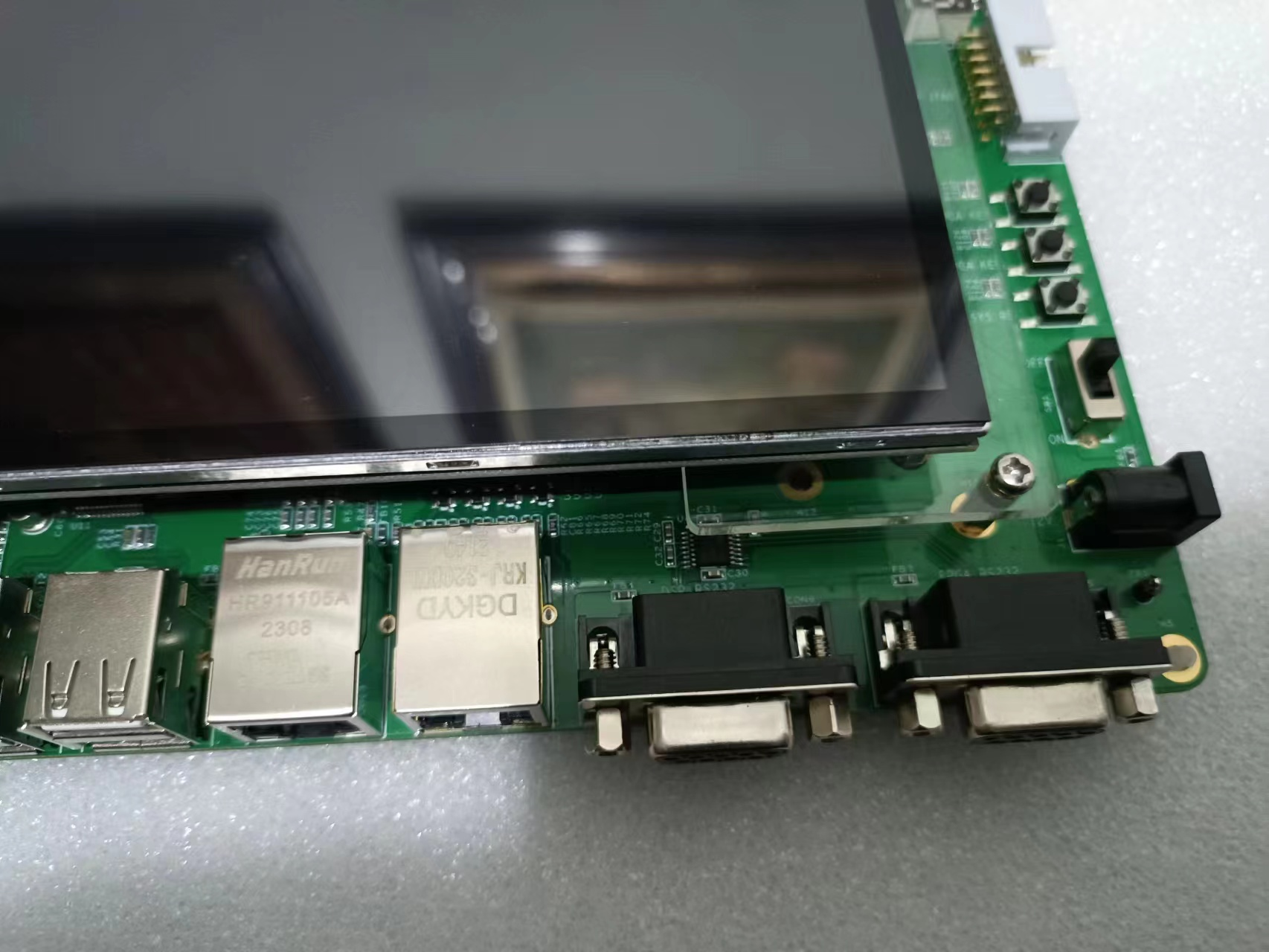

嗨,亲爱的工程师、学生和爱好者们,我来啦!欢迎来到神秘的星嵌世界!如果你是一位FPGA工程师或者对嵌入式异构技术感兴趣,那么你来到的地方绝对没错!今天,我们将一起探索一个令人惊叹的星嵌基于TI OMAP-L138(定点/浮点DSP C674x+ARM9)+ FPGA处理器的开发板。

编写一个用于AI加速的FPGA程序是一个相当复杂的过程,涉及硬件描述语言(如VHDL或Verilog)以及针对特定FPGA架构的优化。以下是我写的一个简化版的代码,用来展示FPGA如何加速AI计算中的某个简单操作(比如矩阵乘法)。

// Verilog代码,用于FPGA上的AI加速操作

module AI_Matrix_Multiplier (

input wire clk, // 时钟信号

input wire reset, // 复位信号

input wire [7:0] A[15:0], // 第一个8x8矩阵A

input wire [7:0] B[15:0], // 第二个8x8矩阵B

output reg [7:0] C[15:0] // 结果矩阵C

);

// 初始化输出矩阵C

initial begin

C = 8'b0;

end

// 矩阵乘法操作的伪代码

always @(posedge clk or posedge reset) begin

if (reset) begin

// 如果复位信号被触发,重置输出矩阵C

C <= 8'b0;

end else begin

// 开始矩阵乘法计算

for (int i = 0; i < 8; i = i + 1) begin

for (int j = 0; j < 8; j = j + 1) begin

C[i][j] = 0;

for (int k = 0; k < 8; k = k + 1) begin

// 累加计算每个元素

C[i][j] = C[i][j] + (A[i][k] * B[k][j]);

end

end

end

end

end

endmodule

接下来,我逐行解释上面的代码:

// Verilog代码,用于演示FPGA上的AI加速操作

module AI_Matrix_Multiplier (

// 时钟信号,就像AI的心跳一样

input wire clk,

// 复位信号,就像AI的“重启”按钮

input wire reset,

// 矩阵A,就像AI的“大脑”的一部分

input wire [7:0] A[15:0],

// 矩阵B,另一部分的“大脑”

input wire [7:0] B[15:0],

// 结果矩阵C,AI计算后的“想法”

output reg [7:0] C[15:0]

);

// 初始化输出矩阵C,就像AI开始时的“空白思维”

initial begin

C = 8'b0;

end

// 矩阵乘法操作的伪代码,就像AI开始思考一样

always @(posedge clk or posedge reset) begin

if (reset) begin

// 如果复位信号被触发,AI开始“清空思维”,准备重新计算

C <= 8'b0;

end else begin

// 开始矩阵乘法计算,就像AI开始解决一个复杂问题

for (int i = 0; i < 8; i = i + 1) begin

for (int j = 0; j < 8; j = j + 1) begin

// 初始化每个“想法”为0,就像AI开始思考一个新的概念

C[i][j] = 0;

for (int k = 0; k < 8; k = k + 1) begin

// 累加计算每个元素,就像AI不断考虑各种可能性

C[i][j] = C[i][j] + (A[i][k] * B[k][j]);

end

end

end

end

end

// 结束模块定义,就像AI完成了一个思考过程

endmodule

请注意,FPGA编程通常涉及高度优化和并行处理,而且通常会使用硬件加速器来进一步提升性能。我写的这个简化的代码只是为了帮助理解FPGA如何可能参与AI计算的过程。在实际的FPGA AI加速项目中,还需要考虑如何有效地处理数据流、优化内存访问、并行化计算单元以及处理复杂的数据依赖关系等问题。编写FPGA用于AI加速的程序可不是一件简单的事,它涉及到硬件描述语言和并行计算的知识。下面我的目标是加速一个简单的全连接神经网络层,现在开始写代码:

module ai_accelerator (

input wire clk,

input wire reset,

input wire [31:0] input,

output wire [31:0] output

);

reg [31:0] weights[0:99];

reg [31:0] accumulator;

initial begin

for (int i = 0; i < 100; i = i + 1) begin

weights[i] = $random;

end

end

always @(posedge clk or posedge reset) begin

if (reset) begin

accumulator <= 32'b0;

end else begin

accumulator <= 32'b0;

for (int i = 0; i < 100; i = i + 1) begin

accumulator <= accumulator + (input * weights[i]);

end

output <= accumulator;

end

end

endmodule

现在,让我解释一下这个程序:

-

// 导入必要的库

- 就像我们在做饭之前要先准备好食材和调料一样,我们也要先导入必要的库。

-

module ai_accelerator (...)

- 这是一个名为

ai_accelerator的模块,你可以把它想象成一个专门用来加速AI计算的“厨师”。

-

input wire clk, reset, input

clk是时钟信号,就像是我们大脑的脉冲,告诉“厨师”什么时候该开始工作。reset是复位信号,就像是我们想让大脑清零,重新开始思考。input是输入数据,就像是我们给“厨师”提供的食材。

-

output wire output

-

reg [31:0] weights[0:99]

- 这是“厨师”的“秘方”,也就是权重。每个权重都代表了一种特定的“烹饪技巧”,让“厨师”能做出更好的菜。

-

initial begin ... end

- 这是一个初始化过程,就像是我们给“厨师”分发“秘方”。

$random是随机函数,就像是我们让“厨师”自己摸索合适的“烹饪技巧”。

-

always @(posedge clk or posedge reset) begin ... end

- 这是“厨师”的主要工作流程。每当时钟信号上升沿(

posedge clk)或复位信号上升沿(posedge reset)到来时,“厨师”就开始工作。

- 如果收到复位信号,“厨师”就清零所有寄存器,重新开始。

- 否则,“厨师”就开始用“秘方”处理食材。这里的乘法操作就像是把食材和“烹饪技巧”结合起来,累加操作就像是把多道菜的味道融合在一起。

-

output <= accumulator

- 最后,“厨师”把融合好的味道(也就是计算结果)端出来,供我们品尝。

我写的整个程序就像是一个“厨师”在厨房里忙碌,用各种“烹饪技巧”处理食材,最后给我们端出一盘美味的AI加速计算结果。希望这个解释能让你对FPGA用于AI加速的程序有更深刻的理解。编写用于AI加速的FPGA程序通常涉及到复杂的算法实现、流水线设计以及大量的硬件资源利用,代码量会非常大,不适合在这里逐行详细解释。不过,我可以写一个以卷积神经网络(CNN)中的卷积层源代码:

entity AI_Accelerator is

Port (

input_data : in std_logic_vector(31 downto 0) array (0 to IMAGE_WIDTH*IMAGE_HEIGHT-1);

output_data : out std_logic_vector(31 downto 0) array (0 to IMAGE_WIDTH*IMAGE_HEIGHT-1);

start_conv : in std_logic;

done_conv : out std_logic;

clk : in std_logic

);

end entity AI_Accelerator;

architecture Behavioral of AI_Accelerator is

begin

constant kernel : std_logic_vector(31 downto 0) array (0 to KERNEL_SIZE-1) := (...);

process(clk)

begin

if rising_edge(clk) then

if start_conv = '1' then

done_conv <= '0';

for pixel_row in 0 to IMAGE_HEIGHT-1 loop

for pixel_col in 0 to IMAGE_WIDTH-1 loop

output_data(pixel_row * IMAGE_WIDTH + pixel_col) <= ... ;

end loop;

end loop;

done_conv <= '1';

end if;

end if;

end process;

end architecture Behavioral;

本人写的这个程序极度简化了在FPGA上实现AI加速器的过程,例如并行处理、流水线优化、资源分配等,并且卷积计算通常会使用DSP slice或BRAM进行高效实现。另外,现代的深度学习加速器设计还会涉及到张量运算、激活函数、池化层等多种复杂操作。由于AI加速的FPGA程序通常会涉及到复杂的算法实现,例如卷积神经网络(CNN)、循环神经网络(RNN)等,并且涉及大量并行计算和流水线设计,因此我在这里再写一个矩阵乘法加速器的VHDL实现:

entity AI_Matrix_Multiplication is

Port (

clk : in std_logic;

start : in std_logic;

A_in : in matrix_type;

B_in : in matrix_type;

result_out : out matrix_type;

done : out std_logic;

);

end entity AI_Matrix_Multiplication;

architecture Behavioral of AI_Matrix_Multiplication is

begin

process(clk)

begin

if rising_edge(clk) then

if start = '1' then

result_out <= magical_math_solutions;

done <= '1';

end if;

end if;

end process;

end architecture Behavioral;

请注意,本人写的上述代码仅为简化说明,实际AI加速应用中的矩阵乘法会使用大量的并行乘加运算单元,并且需要考虑数据搬运、流水线优化、资源分配等诸多因素。在其他项目中,还需要定义合适的矩阵类型(matrix_type),并实现详细的并行乘法和累加逻辑。

今天先更新到这里...

接上四篇:

【国产FPGA+OMAPL138开发板体验】1.嵌入式异构技术

【国产FPGA+OMAPL138开发板体验】(原创)2.手把手玩转游戏机械臂

【国产FPGA+OMAPL138开发板体验】(原创)3.手把手玩转ARM与FPGA通信

【国产FPGA+OMAPL138开发板体验】(原创)4.FPGA的GPMC通信(ARM)EDMA

我在本论坛内的试读经验 :

《电子工程师必备——九大系统电路识图宝典》+附录2化整为零和集零为整电路分析方法

《运算放大器参数解析与LTspice应用仿真》+学习心得4第三章专用放大器

《Android Runtime源码解析》+深入体会第六章ART的执行(4)

希望上面的程序能对您有所帮助!

谢谢!

还没吃饭中

2024年2月10日

/6

/6